Deckhouse — это полнофункциональная платформа на базе Open Source-компонентов, которая, кроме Kubernetes, включает дополнительные модули для мониторинга, балансировки трафика, автомасштабирования, безопасного доступа и не только. Модули преднастроены, интегрированы друг с другом и готовы к работе. Управление всеми компонентами кластера и платформы, а также их обновление полностью автоматизированы.

Deckhouse в реестре российского ПО и сертифицирован в CNCF.

Установка состоит из следующих этапов:

- Архитектура кластера Kubernetes.

- Рекомендуемые системные требования.

- Подготовка конфигурационного файла.

- Установка Kubernetes-кластера на базе Deckhouse.

- Добавление frontend-узлов.

- Добавление system-узлов.

- Добавление worker-узлов.

- Добавление master-узлов.

- Добавление Local Path Provisioner.

- Установка HELM.

- Добавление балансировщика OpenELB - VIP.

- Добавление Ingress Nginx Controller - LoadBalancer.

- Добавление пользователя для доступа к веб-интерфейсу кластера.

- Привилегии запускаемых нагрузок.

Шаг 1. Архитектура кластера Kubernetes

В рамках статьи рассматривается внедрение инфраструктуры отказоустойчивого кластера Kubernetes на базе платформы Deckhouse.

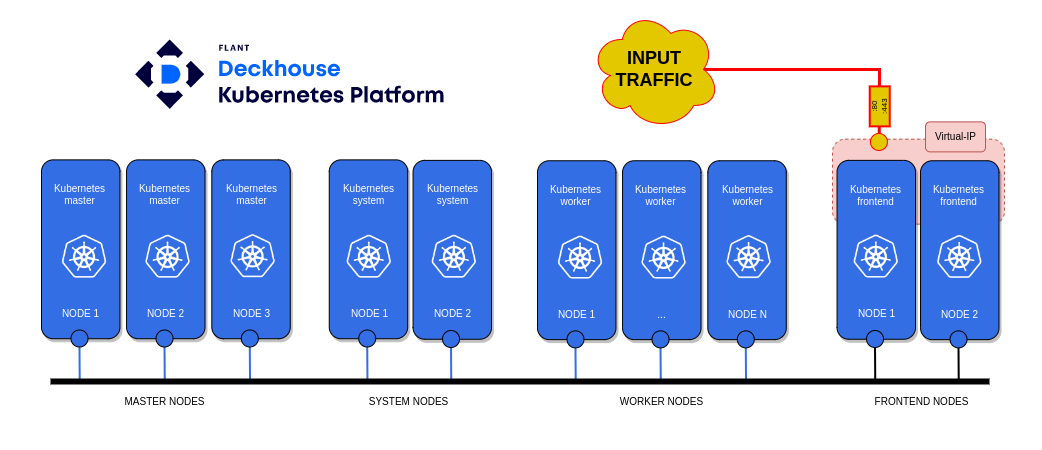

- Структура Kubernetes-кластера.

Чтобы развернуть минимальную структуру Kubernetes-кластера на базе платформы Deckhouse, потребуются:

- персональный компьютер;

- master-узел — три ноды;

- worker-узел — три ноды;

- system-узел — две ноды;

- frontend-узел — две ноды.

В рассматриваемом примере web‑трафик от пользователей поступает на виртуальный IP‑адрес 192.168.1.13, размещённый на frontend-нодах. Шаблон доменного имени для доступа к web-сервисам платформы Deckhouse выберите %s.example.com.

Deckhouse автоматически настраивает и управляет узлами кластера и его компонентами control plane, постоянно поддерживая их актуальную конфигурацию. При развёртывании master-узлов автоматически создаются все необходимые компоненты для control plane с помощью модуля control-plane-manager.

Deckhouse создаёт сущности Kubernetes по мере необходимости и так же их удаляет. Например, если в вашем кластере нет frontend-нод и с master-нод не снято ограничение taint, вы не сможете установить IngressNginxController. В кластере будут отсутствовать необходимые сущности, как ingressClass и так далее. При добавлении system-нод Deckhouse автоматически развернёт компоненты мониторинга и web-сервисы для доступа к интерфейсу платформы. Web-сервисы автоматически привяжутся на %s.example.com.

- Загрузка образов Deckhouse в локальный реестр образов.

Кластер Kubernetes с помощью Deckhouse можно развернуть в закрытом окружении, из которого нет доступа в интернет. Для этого предварительно скачайте на компьютере с доступом в интернет образы платформы Deckhouse и загрузите их в локальный реестр образов. Подробнее читайте в статье «Загрузка образов Deckhouse».

Шаг 2. Рекомендуемые системные требования

- Персональный компьютер.

Компьютер, с которого будет производиться установка. Он нужен только для запуска инсталлятора Deckhouse и не будет частью кластера. Требования:

- ОС: Windows 10+, macOS 10.15+, Linux (Ubuntu 18.04+, Fedora 35+);

- установленный docker для запуска инсталлятора Deckhouse;

- доступ до проксирующего registry или до частного хранилища образов контейнеров с образами контейнеров Deckhouse;

- SSH-доступ по ключу до узла, который будет master-узлом будущего кластера.

- Ноды Kubernetes:

- поддерживаемая ОС;

- конфигурация нод:

Наименование |

vCPU |

RAM (GB) |

Жесткий диск (GB) |

LAN (Gbit/s) |

Kubernetes worker |

8 |

16 |

60 |

1 |

Kubernetes system |

8 |

16 |

200 |

1 |

Kubernetes master |

4 |

8 |

60 |

1 |

Kubernetes frontend |

4 |

6 |

60 |

1 |

- доступ до проксирующего registry или до частного хранилища образов контейнеров с образами контейнеров Deckhouse;

Начало внимание

Deckhouse поддерживает работу только с Bearer token схемой авторизации в registry.

Конец внимание

- доступ до прокси-сервера для скачивания deb/rpm-пакетов ОС при необходимости;

- на узле не должно быть установлено пакетов container runtime, например, containerd или docker.

Начало примечание

Примечание

Установка непосредственно с master-узла в настоящий момент не поддерживается. Установщик в виде Docker-образа нельзя запускать на том же узле, на котором планируется развёртывание master-узла, так как на узле не должно быть установлено пакетов container runtime, например, containerd или docker. При отсутствии менеджмент узлов установите docker на любой другой ноде будущего кластера, запустите Docker-образ установщика, установите Deckhouse и удалите Docker-образ установщика c ноды вместе с docker.

Конец примечание

Шаг 3. Подготовка конфигурационного файла

Чтобы установить Deckhouse, подготовьте YAML-файл конфигурации установки. Для получения YAML-файла конфигурации воспользуйтесь сервисом Быстрый старт на сайте Deckhouse. Сервис сгенерирует актуальный YAML-файл для текущей версий платформы.

- Сгенерируйте YAML-файл сервисом Быстрый старт, выполнив следующие шаги:

- Выберите инфраструктуру — Bare Metal.

- Ознакомьтесь с информацией об установке.

- Укажите шаблон для DNS-имён кластера. В нашем случае — %s.example.com.

- Сохраните

config.yml.

- Внесите необходимые изменения в

config.yml. Для этого выполните следующие действия:

- Задайте адресное пространство подов кластера в podSubnetCIDR.

- Задайте адресное пространство Service’ов кластера в serviceSubnetCIDR.

- Задайте нужную версию Kubernetes в kubernetesVersion.

- Проверьте канал обновления в releaseChannel (EarlyAccess).

- Проверьте шаблон доменного имени в publicDomainTemplate (%s.example.com).

Используется для формирования доменов системных приложений в кластере. Например, Grafana для шаблона %s.example.com будет доступна, как grafana.example.com. - Проверьте режим работы модуля cni-flannel в podNetworkMode.

Режим работы flannel, допустимые значения VXLAN (если ваши сервера имеют связность L3) или HostGW (для L2-сетей). - Укажите локальную сеть, которую будут использовать узлы кластера в internalNetworkCIDRs.

Список внутренних сетей узлов кластера, например,'192.168.1.0/24', который используется для связи компонентов Kubernetes (kube-apiserver, kubelet и т. д.) между собой.

Пример файла первичной конфигурации кластера — config.yml.

Для установки через интернет:

apiVersion: deckhouse.io/v1

kind: ClusterConfiguration

clusterType: Static

podSubnetCIDR: 10.111.0.0/16

serviceSubnetCIDR: 10.222.0.0/16

kubernetesVersion: "Automatic"

clusterDomain: "cluster.local"

---

apiVersion: deckhouse.io/v1

kind: InitConfiguration

deckhouse:

imagesRepo: registry.deckhouse.ru/deckhouse/ce

registryDockerCfg: eyJhdXRocyI6IHsgInJlZ2lzdHJ5LmRlY2tob3VzZS5ydSI6IHt9fX0K

---

apiVersion: deckhouse.io/v1alpha1

kind: ModuleConfig

metadata:

name: deckhouse

spec:

version: 1

enabled: true

settings:

bundle: Default

releaseChannel: EarlyAccess

logLevel: Info

---

apiVersion: deckhouse.io/v1alpha1

kind: ModuleConfig

metadata:

name: global

spec:

version: 2

settings:

modules:

publicDomainTemplate: "%s.elewise.local"

---

apiVersion: deckhouse.io/v1alpha1

kind: ModuleConfig

metadata:

name: user-authn

spec:

version: 2

enabled: true

settings:

controlPlaneConfigurator:

dexCAMode: DoNotNeed

publishAPI:

enabled: true

https:

mode: Global

global:

kubeconfigGeneratorMasterCA: ""

---

apiVersion: deckhouse.io/v1alpha1

kind: ModuleConfig

metadata:

name: cni-cilium

spec:

version: 1

enabled: true

settings:

tunnelMode: VXLAN

---

apiVersion: deckhouse.io/v1

kind: StaticClusterConfiguration

internalNetworkCIDRs:

- 192.168.1.0/24

Для офлайн-установки без доступа в интернет

Начало внимание Для генерации YAML-файла сервисом Быстрый старт выберите инфраструктуру — Закрытое окружение. Конец внимание Установите следующие параметры в ресурсе InitConfiguration:

echo -n "{\"auths\": { \"registry.example.com:443/images/deckhouse\": {}}}" | base64

Пример файла первичной конфигурации кластера — apiVersion: deckhouse.io/v1 |

Шаг 4. Установка Kubernetes-кластера на базе Deckhouse

Установка Deckhouse Platform Community Edition сводится к установке кластера, который состоит из единственного master-узла. Инсталлятор Deckhouse доступен в виде образа контейнера, в который необходимо передать конфигурационные файлы и SSH-ключи доступа на master-узел. Далее подразумевается, что используется SSH-ключ ~/.ssh/id_rsa. В основе инсталлятора лежит утилита dhctl.

- Запустите установщик.

Начало примечание

Примечание

Установка непосредственно с master-узла в настоящий момент не поддерживается. Установщик в виде Docker-образа нельзя запускать на том же узле, на котором планируется развёртывание master-узла, так как на узле не должно быть установлено пакетов container runtime, например, containerd или docker.

Конец примечание

Установщик запускается на персональном компьютере, подготовленном на этапе архитектура кластера Kubernetes. На ПК перейдите в директорию с файлом конфигурации config.yml, подготовленным на этапе подготовка конфигурационного файла.

Для запуска установщика через интернет выполните команду:

sudo docker run --pull=always -it -v "$PWD/config.yml:/config.yml" -v "$HOME/.ssh/:/tmp/.ssh/" registry.deckhouse.io/deckhouse/ce/install:stable bash

Для офлайн-установки без доступа в интернет

sudo docker run --pull=always -it -v "$PWD/config.yml:/config.yml" -v "$HOME/.ssh/:/tmp/.ssh/" example.com:443/images/deckhouse/install:v1.46.3 bash

|

- Установите Deckhouse. Для этого внутри контейнера установщика выполните команду:

dhctl bootstrap --ssh-user=<username> --ssh-host=<master_ip> --ssh-agent-private-keys=/tmp/.ssh/id_rsa \

--config=/config.yml \

--ask-become-pass

где:

<username>— в параметре--ssh-userукажите имя пользователя, от которого генерировался SSH-ключ для установки;<master_ip>— IP адрес master-узла подготовленного на этапе архитектура кластера Kubernetes.

Процесс установки может занять 15-30 минут при хорошем соединении.

Шаг 5. Добавление frontend-узлов

Перед добавлением frontend-нод предварительно создайте новый custom resource NodeGroup с именем frontend. Параметр nodeType в custom resource NodeGroup задайте как Static.

- Создайте на ноде master 1 файл

frontend.yamlс описанием статичной NodeGroup с наименованиемfrontend:

apiVersion: deckhouse.io/v1

kind: NodeGroup

metadata:

name: frontend

spec:

nodeTemplate:

labels:

node-role.deckhouse.io/frontend: ""

taints:

- effect: NoExecute

key: dedicated.deckhouse.io

value: frontend

nodeType: Static

- Примените файл

frontend.yaml, выполнив команду:

kubectl create -f frontend.yaml

- Для добавления frontend-нод выполните следующие действия:

- Получите код скрипта в кодировке Base64 для добавления и настройки нового узла frontend, выполнив команду на ноде master 1:

kubectl -n d8-cloud-instance-manager get secret manual-bootstrap-for-frontend -o json | jq '.data."bootstrap.sh"' -r

- Зайдите на узел, который хотите добавить по SSH (в данном случае frontend 1) и вставьте полученную на первом шаге Base64‑строку:

echo <Base64-КОД-СКРИПТА> | base64 -d | bash

Дождитесь окончания выполнения скрипта. Нода добавлена.

Чтобы добавить новые frontend-ноды, выполните действия из пункта 3.

Шаг 6. Добавление system-узлов

Перед добавлением system-нод предварительно создайте новый custom resource NodeGroup с именем system. Параметр nodeType в custom resource NodeGroup задать как Static.

- Создайте на ноде master 1 файл

system.yamlс описанием статичной NodeGroup с наименованиемsystem:

apiVersion: deckhouse.io/v1

kind: NodeGroup

metadata:

name: system

spec:

nodeTemplate:

labels:

node-role.deckhouse.io/system: ""

taints:

- effect: NoExecute

key: dedicated.deckhouse.io

value: system

nodeType: Static

- Примените файл

system.yaml, выполнив команду:

kubectl create -f system.yaml

- Для добавления system-нод выполните следующие действия:

- Получите код скрипта в кодировке Base64 для добавления и настройки нового узла system, выполнив команду на ноде master 1:

kubectl -n d8-cloud-instance-manager get secret manual-bootstrap-for-system -o json | jq '.data."bootstrap.sh"' -r

- Зайдите на узел, который хотите добавить по SSH (в данном случае system 1) и вставьте полученную на первом шаге Base64‑строку:

echo <Base64-КОД-СКРИПТА> | base64 -d | bash

Дождитесь окончания выполнения скрипта. Нода добавлена.

Чтобы добавить новые system-ноды, выполните действия из пункта 3.

Шаг 7. Добавление worker-узлов

Перед добавлением worker-нод предварительно создайте новый custom resource NodeGroup с именем worker. Параметр nodeType в custom resource NodeGroup задать как Static.

- Создайте на ноде master 1 файл

worker.yamlс описанием статичной NodeGroup с наименованиемworker:

apiVersion: deckhouse.io/v1

kind: NodeGroup

metadata:

name: worker

spec:

nodeType: Static

kubelet:

maxPods: 200

- Примените файл

worker.yaml, выполнив команду:

kubectl create -f worker.yaml

- Для добавления worker-нод выполните следующие действия:

- Получите код скрипта в кодировке Base64 для добавления и настройки нового узла worker, выполнив команду на ноде master 1:

kubectl -n d8-cloud-instance-manager get secret manual-bootstrap-for-worker -o json | jq '.data."bootstrap.sh"' -r

- Зайдите на узел, который хотите добавить по SSH (в данном случае worker 1) и вставьте полученную на первом шаге Base64-строку:

echo <Base64-КОД-СКРИПТА> | base64 -d | bash

Дождитесь окончания выполнения скрипта. Нода добавлена.

Чтобы добавить новые worker-ноды, выполните действия из пункта 3.

Шаг 8. Добавление master-узлов

- Получите код скрипта в кодировке Base64 для добавления и настройки нового узла master, выполнив команду на ноде master 1:

kubectl -n d8-cloud-instance-manager get secret manual-bootstrap-for-master -o json | jq '.data."bootstrap.sh"' -r

- Зайдите на узел, который хотите добавить по SSH (в данном случае master 2) и вставьте полученную на первом шаге Base64-строку:

echo <Base64-КОД-СКРИПТА> | base64 -d | bash

Дождитесь окончания выполнения скрипта. Нода добавлена.

Чтобы добавить новые master-ноды, выполните действия из шага 8.

Шаг 9. Добавление Local Path Provisioner

По умолчанию storageclass отсутствует в Deckhouse. Создайте custom resource LocalPathProvisioner, позволяющий пользователям Kubernetes использовать локальное хранилище на узлах. Для этого выполните следующие действия:

- Создайте на master-узле файл

local-path-provisioner.yaml, содержащий конфигурацию для LocalPathProvisioner.

- Установите нужную Reclaim policy (по умолчанию устанавливается Retain). В рамках статьи для параметра

reclaimPolicyустановлено"Delete"(PV после удаления PVC удаляются).

Пример файла local-path-provisioner.yaml:

apiVersion: deckhouse.io/v1alpha1

kind: LocalPathProvisioner

metadata:

name: localpath-deckhouse-system

spec:

nodeGroups:

- system

- worker

path: "/opt/local-path-provisioner"

reclaimPolicy: "Delete"

- Примените файл

local-path-provisioner.yamlв Kubernetes. Для этого выполните команду:

kubectl apply -f local-path-provisioner.yaml

- Установите созданный LocalPathProvisioner, как storageclass по умолчанию (default-class), выполнив одну из команд:

kubectl patch storageclass localpath-deckhouse-system -p '{"metadata": {"annotations":{"storageclass.kubernetes.io/is-default-class":"true"}}}'

или

sudo -i d8 k patch mc global --type merge -p “{"spec": {"settings":{"defaultClusterStorageClass":"localpath-deckhouse-system"}}}”

LocalPathProvisioner с наименованием localpath-deckhouse-system создан и готов предоставлять локальные хранилища на узлах c NodeGroup system и worker.

Шаг 10. Установка HELM

- Перейдите на страницу релизов Helm и скачайте архив

helm-vX.Y.Z-linux-amd64.tar.gzнужно версии.

Для установки через интернет:

wget https://get.helm.sh/helm-vX.Y.Z-linux-amd64.tar.gz

Для офлайн-установки без доступа в интернет

wget https://get.helm.sh/helm-vX.Y.Z-linux-amd64.tar.gz

|

- Распакуйте архив и переместите бинарный файл helm:

tar -zxvf helm-vX.Y.Z-linux-amd64.tar.gz

mv linux-amd64/helm /usr/local/bin/helm

Шаг 11. Добавление балансировщика OpenELB-VIP

Для правильной работы Ingress-контроллера требуется прямой выход в интернет с белым IP-адресом на Ingress-узле кластера с использованием NodePort, или можно установить балансировщик OpenELB, который будет заниматься балансировкой трафика так, как это организовано у любого облачного провайдера. Этот балансировщик использует Speaker для поддержки IP-адреса службы.

Разверните OpenELB в режиме VIP Mode. Для этого:

- Получите конфигурационный файл

values-openelb.yaml.

Для установки через интернет:

helm repo add elma365 https://charts.elma365.tech

helm repo update

helm show values elma365/openelb > values-openelb.yaml

Получение конфигурационного файла для установки в закрытом контуре без доступа в интернет

helm repo add elma365 https://charts.elma365.tech

tar -xf openelb-X.Y.Z.tgz |

- Измените конфигурационный файл

values-openelb.yaml.

Запланируйте размещение подов openelb-controller на frontend-нодах кластера. Для этого измените секции tolerations и nodeSelector:

## Настройки openelb

openelb:

speaker:

enable: true

vip: true

apiHosts: ":50051"

tolerations:

- key: CriticalAddonsOnly

operator: Exists

- effect: NoExecute

key: dedicated.deckhouse.io

operator: Equal

value: frontend

nodeSelector:

kubernetes.io/os: linux

node-role.deckhouse.io/frontend: ""

controller:

webhookPort: 443

tolerations:

- key: CriticalAddonsOnly

operator: Exists

- effect: NoExecute

key: dedicated.deckhouse.io

operator: Equal

value: frontend

nodeSelector:

kubernetes.io/os: linux

node-role.deckhouse.io/frontend: ""

...

## Настройки openelb где формат |

- Установите OpenELB в Kubernetes.

Для установки через интернет:

helm upgrade --install openelb elma365/openelb -f values-openelb.yaml -n openelb-system --create-namespace

Для установки без доступа в интернет

helm upgrade --install openelb ./openelb -f values-openelb.yaml -n openelb-system --create-namespace |

- Настройте отказоустойчивость openelb-controller.

Для достижения отказоустойчивости увеличьте количество реплик openelb-controller, выполнив команду на ноде master 1:

kubectl scale --replicas=2 deployment openelb-controller -n openelb-system

Выполните следующую команду, чтобы проверить находится ли openelb-controller в состоянии READY: 1/1 и STATUS: Running. Если да, OpenELB успешно установлен.

kubectl get po -n openelb-system

- Создайте пул IP-адресов для OpenELB.

Создайте на ноде master 1 файл vip-eip.yaml с описанием EIP‑объекта. Объект Eip функционирует как пул IP-адресов для OpenELB.

Пример файла vip-eip.yaml:

apiVersion: network.kubesphere.io/v1alpha2

kind: Eip

metadata:

name: vip-eip

annotations:

eip.openelb.kubesphere.io/is-default-eip: "true"

spec:

address: 192.168.1.13

protocol: vip

interface: ens18

Примените файл vip-eip.yaml в Kubernetes, выполнив команду:

kubectl apply -f vip-eip.yaml

- Переместите поды keepalived на frontend-узлы.

По умолчанию поды keepalived размещаются openelb-manager на worker-узлах. В рамках статьи поды keepalived нужно разместить на frontend‑узлах.

Внесите изменения в DaemonSet openelb-keepalive-vip, выполнив команду на ноде master 1:

kubectl patch ds -n openelb-system openelb-keepalive-vip -p '{"spec":{"template":{"spec":{"nodeSelector":{"kubernetes.io/os":"linux","node-role.deckhouse.io/frontend":""},"tolerations":[{"key":"dedicated.deckhouse.io","value":"frontend","effect":"NoExecute"}]}}}}'

Проверьте, что изменения, внесённые в DaemonSet openelb-keepalive-vip применились и поды разместились на нодах frontend:

kubectl get po -o wide -n openelb-system

Шаг 12. Добавление Ingress Nginx Controller - LoadBalancer

Deckhouse устанавливает и управляет NGINX Ingress Controller при помощи Custom Resources. Если узлов для размещения Ingress-контроллера больше одного, он устанавливается в отказоустойчивом режиме и учитывает все особенности реализации инфраструктуры облаков и bare metal, а также кластеров Kubernetes различных типов.

- Создайте на ноде master 1 файл

ingress-nginx-controller.yml, содержащий конфигурацию Ingress-контроллера.

Пример файла ingress-nginx-controller.yml

|

- Примените файл

ingress-nginx-controller.ymlв Kubernetes, выполнив команду:

kubectl create -f ingress-nginx-controller.yml

После установки ingress-контроллера Deckhouse автоматически создаст сервис nginx-load-balancer в namespace d8-ingress-nginx, но не свяжет данный сервис с OpenELB.

- Проверьте, что изменения, внесённые в сервис nginx-load-balancer применились, в EXTERNAL-IP появился IP-адрес 192.168.1.13. Для этого выполните следующую команду:

kubectl get svc -n d8-ingress-nginx

Шаг 13. Добавление пользователя для доступа к веб-интерфейсу кластера

- Создайте на ноде master 1 файл

user.yml, содержащий описание учётной записи пользователя и прав доступа.

|

- Примените файл

user.ymlв Kubernetes, выполнив команду:

kubectl create -f user.yml

Шаг 14. Привилегии запускаемых нагрузок

Разрешите переназначить политику привилегий для запускаемых подов:

kubectl label namespace elma365 security.deckhouse.io/pod-policy=privileged --overwrite